一 : 谷歌修改图片搜索算法防止用户偶遇色情内容

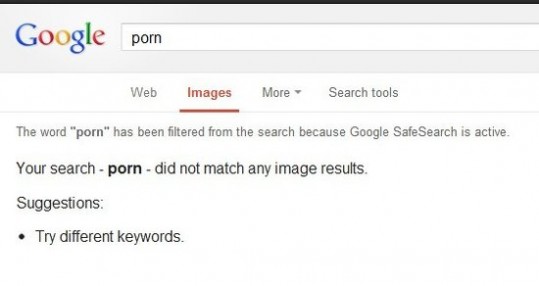

腾讯科技讯(晁晖)北京时间12月13日消息,据国外媒体报道,谷歌昨晚修改了图片搜索算法,减少了用户偶然搜索到色情图片的机率。

谷歌一名代表在解释修改图片搜索算法时说,“我们不会屏蔽任何成人内容,希望向用户提供他们想要搜索的内容,除非用户确实在搜索这样的内容,我们不会向用户提供与性有关的图片。我们利用算法选择与特定关键字相关度最高的搜索结果。如果用户确实在搜索成人内容,无需修改缺省设置,用户就可以搜索到这类内容,需要的仅仅是在搜索关键字中更明确地表明这一点。图片搜索设置与网页搜索完全相同。”

换句话说,如果关闭SafeSearch,只要在搜索关键字中增添“porn”(色情),用户仍然能搜索到自己想要的内容。

谷歌表示,这次算法修改只是使图片搜索设置与现有的网页和视频搜索相一致。但值得指出的是,对于一贯以方便用户搜索想要的内容为目标的谷歌而言,此举显得不同寻常。

二 : 谷歌图片搜索“重男轻女”,这你造吗?

继搜索引擎会让我们误以为自己很聪明后,它又会给我们带来偏见。不是所有的医生和CEO都是男性,不是所有的护士都是女性。但是,在谷歌图片里我们搜索到的是啥?

如果我们搜索护士,一水的姑娘(哟,有一个除外)。

如果我们搜索医生,绝大部分是男哒。

如果我们搜索CEO,呵呵。

华盛顿大学与马里兰大学的最新研究证明,某些工作的图片搜索结果带有明显的性别偏见,而这会影响人们在现实世界中关于职业性别比率的认知。

研究人员观察了45种不同工作的前100个图片搜索结果,然后,将这些结果与美国劳工统计局针对每个工作的实际性别统计结果进行比对。

以“CEO”为例,谷歌图片的性别失衡远远大于现实生活:劳工统计局的数据显示女性CEO占27%,而谷歌图片显示的女性CEO仅占11%。如果搜索“电话销售员”,图片结果显示64%为女性,而在现实中男女比例各占50%。近60%的调酒师都是女性,但在图片搜索结果中,只有23%。

如果搜索“女性建筑工”,瞧瞧,好多搔首弄姿的模特。

谷歌图片搜索,如同谷歌的其他搜索工具,旨在用算法得出你想得到的搜索结果。谷歌的搜索考虑到很多因素,比如关键词、内容的及时性、用户的登陆IP、搜索记录、网站排名等等。

可(www.61k.com]悲的是,在搜索中显示的性别偏见实际上做对人们如何看待性别故障在现实世界中的作用,根据这项研究。在被扭曲的显示图像效果有一定的职业,研究参与者所做报告中的一个领域是如何男性主导的是他们的看法略有变化。

当然,“重男轻女”并不完全是谷歌的错,它只是互联网上大千世界的一个映射。雅虎、Bing的搜索结果也是如此。

研究人员希望人们至少意识到问题的存在,也建议搜索引擎的设计者可以利用这些研究成果开发更好的算法,减少性别偏见。

viahuffingtonpost

三 : 谷歌的图片搜索原理

谷歌的图片搜索原理

很多人都用过Google图片搜索功能。你可以用一张图片,搜索互联网上所有与它相似的图片。

你输入网片的网址,或者直接上传图片,Google就会找出与其相似的图片。下面这张图片是美国女演员AlysonHannigan

。上传后,Google返回如下结果:

这种技术的原理是什么?计算机怎么知道两张图片相似呢?

根据NealKrawetz博士的解释,原理非常简单易懂。我们可以用一个快速算法,就达到基本的效果。

这里的关键技术叫做"感知哈希算法"(Perceptualhashalgorithm),它的作用是对每张图片生成一个"指纹"(fingerprint)字符串,然后比较不同图片的指纹。结果越接近,就说明图片越相似。下面是一个最简单的实现:

第一步,缩小尺寸。

将图片缩小到8x8的尺寸,总共64个像素。这一步的作用是去除图片的细节,只保留结构、明暗等基本信息,摒弃不同尺寸、比例带来的图片差异。

第二步,简化色彩。

将缩小后的图片,转为64级灰度。也就是说,所有像素点总共只有64种颜色。

第三步,计算平均值。

计算所有64个像素的灰度平均值。

第四步,比较像素的灰度。

将每个像素的灰度,与平均值进行比较。大于或等于平均值,记为1;小于平均值,记为0。

第五步,计算哈希值。

将上一步的比较结果,组合在一起,就构成了一个64位的整数,这就是这张图片的指纹。组合的次序并不重要,只要保证所有图片都采用同样次序就行了。

得到指纹以后,就可以对比不同的图片,看看64位中有多少位是不一样的。在理论上,这等同于计算"汉明距离"(Hammingdistance)。

如果不相同的数据位不超过5,就说明两张图片很相似;如果大于10,就说明这是两张不同的图片。

具体的代码实现,可以参见Wote用python语言写的imgHash.py。代码很短,只有53行。使用的时候,第一个参数是基准图片,第二个参数是用来比较的其他图片所在的目录,返回结果是两张图片之间不相同的数据位数量(汉明距离)。

这种算法的优点是简单快速,不受图片大小缩放的影响,缺点是图片的内容不能变更。如果在图片上加几个文字,它就认不出来了。所以,它的最佳用途是根据缩略图,找出原图。

实际应用中,往往采用更强大的pHash算法和SIFT算法,它们能够识别图片的变形。只要变形程度不超过25%,它们就能匹配原图。这些算法虽然更复杂,但是原理与上面的简便算法是一样的,就是先将图片转化成Hash字符串,然后再进行比较。

四 : 谷歌执行主席施密特:谷歌图片搜索因女星洛佩兹诞生

【TechWeb报道】4月9日消息,据国外媒体报道,谷歌执行主席埃里克·施密特撰文称,谷歌图片搜索(Google Image Search)是受詹妮弗·洛佩兹(Jennifer Lopez)启发而诞生的。

在Project Syndicate网站上发表的文章里,施密特表示,谷歌上线之后,联合创始人佩奇和布林在不停地迭代创新,其中谷歌图片搜索的诞生非常有意思。

施密特称,在2000年前后,人们对非文字搜索的需求变得非常明显,尤其是在2000年格莱美颁奖典礼后,上图穿绿色半透明的裙子的詹妮弗·洛佩兹吸引了全世界的目光,洛佩兹成了谷歌上线以来最热门的搜索。施密特写道,“我们得确保用户得到他们想要的搜索结果,那就是穿着那条裙子的洛佩兹,于是谷歌图片搜索诞生了。”

五 : 谷歌调整算法:加大色情图片搜索难度

北京时间12月13日早间消息,谷歌刚刚对图片搜索算法进行了调整,无论是否有意搜索色情图片,这类内容的搜索难度都将加大。

谷歌发言人解释了这一调整:“我们不会审查任何成人内容,而且希望向用户展示他们所寻找的内容——但除非用户明确搜索色情内容,否则我们不希望展示这类信息。我们使用算法为搜索请求选择最相关的结果。如果你搜索成人内容,无需更改默认设置即可找到——如果你的搜索词模糊不清,你只需要进一步明确搜索请求即可。图片搜索的设置现在也采用了与网络搜索相同的方式。”

换句话说,如果用户关闭了“安全搜索”(SafeSearch),并在关键词中附带“色情”之类的明确词汇,仍然可以找到色情内容。

但此举或许不足以满足部分用户的要求。有用户在Reddit中发帖称,即使关闭“安全搜索”,也很难找到明确的色情内容。

谷歌表示,此举只是将图片搜索的设置与现有的网络和视频搜索保持一致。但值得注意的是,谷歌以往的改版都是为了方便用户寻找内容,而本次却反其道而行之,因此显得不同寻常。

本文标题:谷歌图片搜索-谷歌修改图片搜索算法防止用户偶遇色情内容61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1