一 : 从五个方面浅析搜索引擎算法

搜索引擎算法每一次的变动都会牵动着广大站长的心,每个站长都非常想知道搜索引擎的算法是怎样的?如果彻底了解到了搜索引擎的排序准则,那么一定能够让你非常快速的将自己的网站优化到前面,可是搜索引擎的算法却是非常的繁难,对于一名普通的个人站长要想窥探出其中的奥秘,那比登天还难,不过没有关系,我们可以从其他的途径来了解搜索引擎,下面我就将我的经验写出来跟大家分享一下!

一:从网站的结构

搜索引擎的工作原理大体分为爬行,抓取,索引和排序四个步骤,因为搜索引擎需要遍历你的网站所有页面,就好像一个蜘蛛能够迅速的遍历自己织的网一样,所以我们又把搜索引擎成为蜘蛛,而我们打造的网站就是网,而网站的结构就是网,如果网做的好,那就很容易让搜索引擎爬行,做的不好,蜘蛛就不愿意爬行,你的网站被收录的可能性就很小,所以在建设网站的时候就一定要充分考虑到网站的结构,要搭建一个让蜘蛛爬行的非常愉快的结构!

二:明确主题

网站的主题明确也就是关键词非常明确,如果你的网站关键词多变,或者整个网站主题非常混乱,蜘蛛爬行半天都不知道你的网站纲在哪里,到处都是网线,纲不举自然就没有办法让蜘蛛确认你的网站的主题,关键词在网站的分布一定要合理,这也可以参考蜘蛛网的纲,通常都是等距离会出现一个纲线,也就是说网站的内容里面的关键词也要合适的分布,这样才能够让你的网站呈现纲举目张的效应!

三:用户体验

对于站长们来说都非常的清楚用户体验是非常重要的,有的人为了增强用户的体验性甚至不惜伤害搜索引擎,当然搜索引擎也是非常注重用户体验的,一旦发现自己的算法有违背用户体验的,肯定会很快的修正过来,所以做网站要想得到搜索引擎的青睐,首先就要想办法获得用户的青睐,只有让用户和搜索引擎都喜欢上你的网站,那么你的网站就一定能够成功,要流量有流量,要流量转化率就有流量转化率,想要盈利自然很简单了!

四:加强外链建设

网站的外链是非常重要的,外链越多,你在互联网上曝光的几率就越高,蜘蛛就越容易找到你,每天蜘蛛在爬行别人的网站时总是能够找到你的网站链接,说明你这个网站非常的重要,自然能够让你的网站获得更好的排名,所以网站的外链建设是非常重要的!当然外链的质量也要看重,不能够尽做一些垃圾外链,这样反而得不偿失!

五:每天给用户提供有用的信息

你的网站之所以能够被用户喜欢,是因为你能够提供帮助给用户,如果你的网站内容非常差,根本帮不到用户,那么他们也就只会看看,不会来你网站的,所以每天更新文章就显得非常的重要,更新的文章要能够给用户带来有用的信息,而不是那种东拼西凑的东西,或者采集而来的信息,这些都不利于搜索引擎的爬行收录的!

上面的五个方面算是针对搜索引擎算法的一些优化方法,个人觉得,只要认真做好这五个方面,就算是跟进了搜索引擎算法的脉搏了,就算是搜索引擎不断的变化,万变不离其宗,这五个方面就是这个宗!你做好了,自然你的网站排名就有了!来源:http://www.leftcarnitine.com 左旋肉碱有用吗原创A5首发,转载请保留。

二 : 搜索引擎判断站群链接的几种方法小结

搜索引擎是怎样判断站群链接的?三 : 搜索引擎对重复内容的处理方法

#1 从博客上复制内容:

上图是主要针对博客这种网站媒体类型的,我们使用wordpress的时候经常将文章毫无保留地展示在首页,而不是使用输出摘要(就好像SEMWATCH那样),根据Randfish观察,其实这样子是会搜索引擎误认为内容重复。

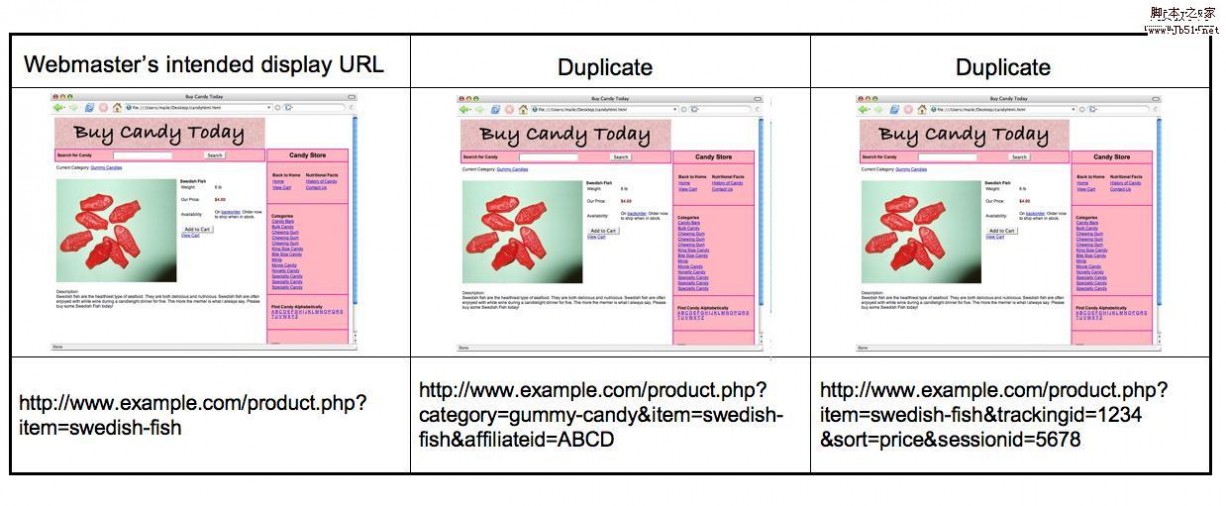

#2 URL参数引起的内容重复

究竟URL参数像Session IDs,Tracking IDs是怎样引起内容重复的呢?Googlewebmastercentral (需要翻墙) 透露,同一个产品页面,如果搜索引擎爬虫抓取可以通过多种链接途径抓取同一个产品页面,那样会有以下几种消极的影响:

1.多种URLs会稀释链接的广泛性。比如上图的产品页面,如果有50个导入链接,那有可能分别形成了3种导入URL途径,而不是唯一的某一个URL,这样就等于将导入链接传递的权重分散到3个不同的链接上。

2.搜索结果或许会呈现不友好的URL(比如一大串长长 的session ID,tracking ID)。从而在SERP中,降低了用户对该页面的清晰了解程度(英文url比如semwatch.org/sem,不仅仅具备搜索引擎友好性,更重要的是用户体验友好性),不利于品牌的塑造。

#3 搜索引擎对待内容重复的态度

从Search Engine Land给出上图可知,一般来说搜索引擎通过4个步骤来识别内容是原创还是复制:

1.发现。当搜索引擎爬虫发现新的内容,他会立刻与之前收录的内容进行比较确保内容的原创性。

2.丢弃。首先,搜索引擎会放弃收录那些来自链接工厂,MFA站点(Made For Adense)和被列入黑名单的IP的页面

3.解剖。下一步就是分析每个页面的 入站链接,判断链接的质量和源头。

4.决定。最后就是回顾之前收录的页面和相关链接,决定哪一个页面才是绝对原创。

#4 关键词拆解

搜索引擎会蜘蛛通过你的某一个特定页面爬行4个或者40个网站上不同的页面,而这种行为一般是通过该页面的相关内容链接进行爬行抓取(比如上图的“滑雪板),很多朋友希望通过将众多页面相互关联起来即使相互之前没有关联性,一个站点的许多页面过度使用同一个关键词,从而为了提高排名。但是事实上,这种行为对于排名是帮助不大的。

#5 怎样处理好内容重复的情况

这里不同在于不是仅仅通过“滑雪板”这个词而是通过各种各样,有价值而且唯一的关键词(比如折扣滑雪板,小孩滑雪板等)链接到原来的内容上。这样搜索引擎就可以很容易确定该页面与其他页面的相关性极强,这不仅仅基于搜索引擎友好性,更是考虑到用户体验与网站未来的信息架构。

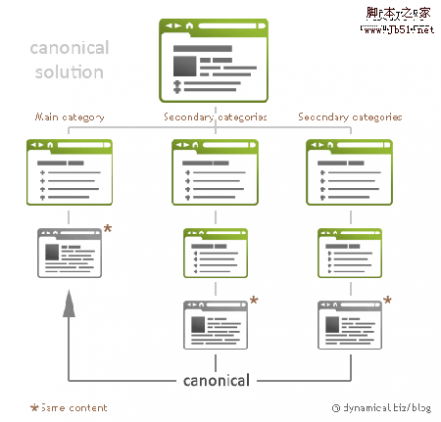

Canonical标签

Source: Dynamical.biz

Source: SEOmoz.org

其实上面两幅图都涉及到一个问题,那就是网址规范化,针对这个问题,Zac前辈很早前就给我们分析过—网址规范化问题最新解决方法,大家可以前往学习。

301重定向

301重定向也是解决内容重复的重要方法,对于永久的重定向,搜索引擎更偏爱于301重定向。随着301重定向实施,旧网站的权重就会自动传递到新的网站上。

当各位了解了搜索引擎对于内容重复判断机制以后,相信对各位的优化工作会有所帮助。我们经常说“细节制胜”,所以无论是网络营销还是单纯的SEM都必须遵循这样的一个原则和细节,方能制胜。

图表收集:Ann Smarty,原文链接 本文首发 SEM Watch ,转载请注明出处

四 : 搜索引擎优化作弊常见的10种方法

在此我们列出被Google明令禁止的属 SPAM性质的优化技术供大家借鉴。

优化的方式形形色色,一般无外乎按照一定的关键词,通过对网站结构,页面因素和外部链接的优化,使网站得到最佳的搜索引擎排名。但事实上我们发现,有一些网站由于采取了不正确的优化策略,不但未能有效提升网站的排名,反而使网站排名惨跌甚至遭到搜索引擎删除。

在此我们列出被Google明令禁止的属 SPAM性质的优化技术供大家借鉴。

一:隐藏文本/隐藏链接

一般指网页专为搜索引擎所设计,但普通访问者无法看到的文本内容或链接。在形形色色的隐藏技术中,最常见的就是把文本或链接文字的字体颜色设置为与背景色相同或十分接近。

隐藏文本内容(Invisable/hidden text)

意欲在不影响网站美观的前提下通过包含大量关键词的网页提高关键词相关性得分,从而达到改善搜索引擎排名的目的。

隐藏链接(Invisable/hidden links)

意欲在不影响网站美观的前提下通过在其它页面添加指向目标优化页的隐形链接,通过提升链接得分而改善搜索引擎排名。

现在大多数搜索引擎都能检测隐藏技术,并视为作弊。因而包含隐含文本的网页面临被搜索引擎降低排名甚至删除列表的惩罚。虽然在Google上不乏使用隐形技术而侥幸逃脱的网站,但多数人还是认为不值得冒这个险。其实通过添加可视文本内容并保证一定的关键词密度可达到相同的优化效果。

二:网页与Google描述不符

一般发生于先向搜索引擎提交一个网站,等该网站被收录后再以其它页面替换该网站。“诱饵行为(Bait-&-Switch)”就属于此类偷梁换柱之举–创建一个优化页和一个普通页,然后把优化页提交给搜索引擎,当优化页被搜索引擎收录后再以普通页取而代之。

三:误导性或重复性关键词

误导性关键词(Misleading Words)

在页面中使用与该网页毫不相干的误导性关键词来吸引查询该主题的访问者访问网站。这种做法严重影响了搜索引擎所提供结果的相关性和客观性,为搜索引擎所深恶痛绝。

重复性关键词(Repeated Words)

这种作弊技术也被称为“关键词堆砌欺骗(Keyword Stuffing)”,它利用搜索引擎对网页正文和标题中出现的关键词的高度关注来对关键词进行不合理的(过度)重复。类似的其它做法还包括在HTML元标识中大量堆砌关键字或使用多个关键字元标识来提高关键词的相关性。这种技术很容易被搜索引擎察觉并受到相应惩罚。

四:隐形页面(Cloaked Page)

对实际访问者或搜索引擎任一方隐藏真实网站内容,以向搜索引擎提供非真实的搜索引擎友好的内容提升排名。

五:欺骗性重定向(Deceptive redirects)

指把用户访问的第一个页面(着陆页)迅速重定向至一个内容完全不同的页面。

“鬼域(Shadow Domain)”

这是最常见的欺骗性重定向技术,通过欺骗性重定向使用户访问另外一个网站或页面。一般利用HTML刷新标识(Meta Refresh)来实现。大多搜索引擎都不会索引使用该标识的页面。如果你使用刷新标识来检测浏览器或分辨率,那么就请使用javascript,且尽可能延长重定向时间。如果一定要使用重定向功能,那么请务必确保刷新周期不少于10秒钟。

还有一种情况就是当用户打开一个网站,该网站声称其网站已移至新域名下,并请用户点击新域名链接进入网站。但当用户进去后才发现,这个链接是一个“会员”链接。这也属欺骗性重定向行为。

六:门页(Doorway Page)

也叫“Bridge/Portal/Jump/Entry Page”。是为某些关键字特别制作的页面,专为搜索引擎设计,目的是提高特定关键词在搜索引擎中的排名所设计的富含目标关键词的域名,且重定向至另一域名的真实网站。搜索引擎的Spiders往往忽略对那些自动重定向到其它页的页面的检索。

七:复制的站点或网页

最常见的当属镜象站点(Mirror Sites)。通过复制网站或卬页的内容并分配以不同域名和服务器,以此欺骗搜索引擎对同一站点或同一页面进行多次索引。现在大多数搜索引擎都提供有能够检测镜象站点的适当的过滤系统,一旦发觉镜象站点,则源站点和镜象站点都会被从索引数据库中删除。

八:作弊链接技术/恶意链接(Link Spamming)

典型的作弊链接技术包括:

链接工厂(link farms)

大宗链接交换程序(bulk link exchange programs)

交叉链接(Cross Link)

“链接工厂”(亦称“大量链接机制”)指由大量网页交叉链接而构成的一个网络系统。这些网页可能来自同一个域或多个不同的域,甚至可能来自不同的服务器。一个站点加入这样一个“链接工厂”后,一方面它可得到来自该系统中所有网页的链接,同时作为交换它需要“奉献”自己的链接,籍此方法来提升链接得分,从而达到干预链接得分的目的。如今搜索引擎发现它们已然不费吹灰之力。只要发现,不管属有意还是无意,“链接工厂”中的所有站点都难逃干系。

九:日志欺骗行为

通过对一些页面等级较高的站点进行大量的虚假点击以求名列这些站点的最高引用者日志中,从而获得它们的导入链接。Google已然意识到这种行为并将对利用这种途径获得导入链接的站点采取相应措施。

十:门域(Doorway Domain)

专为提高特定关键词在搜索引擎中的排名所设计的富含目标关键词的域名,然后重定向至其它域名的主页。由于搜索引擎一般忽略自动重定向至其它页的页面的检索,所以不提倡使用这种技术。

本文标题:搜索引擎优化方法-从五个方面浅析搜索引擎算法61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1