一 : 分析谷歌对PDF文件的索引功能

简单的答案是肯定的-谷歌自2001年以来一直能够索引PDF文件。然而,经常被问的问题是他们能在多大程度上由于其中非HTML文件的搜索引擎机器人可以抓取。先进的谷歌机器人不停止这些障碍,所以幸运的是PDF格式的出版物的内容不应该妨碍你的搜索引擎优化的努力。这里派上用场,关于谷歌如何处理PDF文件和索引什么程度,可能出现的一些事实:

1、谷歌索引所有类型的PDF文件吗?

幸运的是,谷歌可以访问和索引PDF文件的大部分,但也有少数例外。PDF格式的加密或密码保护的是人迹罕至的搜索引擎,例如。谷歌给出的规则是,如果你可以从PDF文件复制文本并粘贴到一个标准的文本文件,然后他们应该希望能够索引它。

2、Google索引中的图像从PDF文件吗?

谷歌无法索引,直接从PDF文件的图像,除非他们有一个单独的HTML页面,为他们设立的。即使在标准网页的Google不能索引图像准确,除非他们是由于相关和描述的“ALT标签” - 这使他们当他们在PDF文件中包含的搜索引擎访问。

3、Google索引中的链接在PDF文件吗?

PDF文件中的链接被视为同样标准的HTML链接。唯一例外的是,在PDF文件中的链接不能有'nofollow的'属性,重视他们,但他们仍然可以通过PageRank和其他各种有关权威排名信号。放置在一个PDF文件的链接甚至可能会随后通过搜索引擎抓取和索引文件本身已经后。

4、你可以停止/删除SERP中的PDF文件?

你可以停止从被抓取PDF文件,你可以从结果页面已索引的PDF文档。双方的解决方案是在HTTP头文件被送达使用以下命令:X-Robots-标签:NOINDEX,这将阻止PDF文件被搜索引擎访问,因此它不会出现在结果页面。如果该文件已经被索引,那么上面的命令仍然可以被用来和PDF的房源将下降随着时间的推移。

5、它被归类为HTML和PDF格式的网页中存在重复的内容,如果副本?

谷歌一直认为只有一个版本的页面服务的搜索引擎,以避免发生这种问题。如果相同的内容将要被用于在HTML格式的多个页面上的解决办法是使用“REL =规范”标签提名为指数化的一个版本。这同样适用于HTML和PDF版本之间的内容重复。规范的版本,可以指定在网页的HTML编码,或在PDF文件源的HTTP头。包括在Sitemaps中的URL地址,也可以由一个指数化的首选版本。

6、PDF文件将排在搜索引擎结果页的高度吗?

PDF文件可以在SERP中的排名。为PDF文件的优化过程中几乎是一样下来整个网站优化过程中的缩放。优秀的内容,在一个多样化的和权威性的链接组合的PDF文件,在高度居作为一个优化的网页(如第一张图片所示)有尽可能多的机会。

7、你可以对PDF文件如何在SERP?

谷歌将利用两个因素,以确定如何在SERP中提出了一个PDF文件的标题。这些都是在PDF文件,并??包含指向文件的链接的锚文本的元数据。这些将作为强大的指标应该如何标题的PDF文件,当它被列出的搜索引擎。

同时,优化PDF文件,可能不是大家的最高优先级的SEO策略,我相信这是非常值得知道如何在PDF文件中的内容被搜索引擎处理。PDF格式是伟大的一个可读的方式呈现长文件应被视为宝贵的资源,为公司的生产指南,说明书或任何其他类型的扩展内容。如果您有任何其他查询搜索引擎优化链接建设战略,那么请与我们联系。

内容原创:www.leadseo.cn 转载内容请保留来源地址,谢谢。

二 : 2016影响谷歌搜索引擎排名的几个有利因素及不利因素

新的一年又开始了,有不少读者和我说他的网站上不去。当我问起他做了哪些优化,他便按照某些书本所说的标题标签包含关键词啊,H1标签包含关键词 啊,站内的锚文本用或者标签啊,等等,基本书本所说的他都照做了,而没有效果其实也是情理之中的事情。因 为这些都是别人很多年前总结出来的因素,对于当年确实很有用,但现在很多SEO因素都被削减了排名比重。既然我们要做排名,那我们肯定要先了解到谷歌目前 更看重哪几个点。这里daniel总结了几个2016年,谷歌比较看重的几个有利因素以及不利因素。

影响谷歌搜索引擎排名的有利因素

TR,也就是TrustRank,指的是网站的权威度。意思就是您的网站是否收到来自被信任的网站的链接;

DA, 也就是Dmoain Age, 域名年龄,也称为域名权重,时间越长的域名对排名越有利;

PR, Page Rank, 虽然他影响排名的比重从以前的70%下降到40%,但它仍然是影响排名的主要因素;

更新频率(update frequecy),指的是你的网站更新原创内容的频率;

LSI (Latent Semantic Indexing), 网页是否加入潜在语义索引词来替换部分目标关键词;

Soscial Media,也就是Facebook,Twitter,Pinteret在您的网页表现的数据。(你的页面有多少个赞,多少个转载,以及转载您的文章的改用户的权威度等)

手机自适应,或者使用目前谷歌刚推出的AMP项目,让你的网站在手机端能够更好的展现并且提升加载的速度。

并非H标签,加B标签在主要关键词上这些优化手段完全没用,而是这部分的优化手段已经从“要求”变成了“标配”,所以这里就不一一再多说。

不是把有利因素都做好了排名就上去了,因为在优化的过程中避免不了和不利因素打交道,我们在进行优化的过程中也要注意以下几个谷歌更为看重的不利因素要点:

影响谷歌搜索引擎排名的几个不利因素

页面导出大量不相关的链接,或者导出到不被信任的网站;

网页生成了大量的无价值页面;

反向链接只优化特定的词,目的性过强(参考引入LSI的作用);

站内关键词出现频率过高,优化过度;

在已经被列入链接工场的站长处购买链接;

外链的形式单一,长期从单一的站点内获取链接;

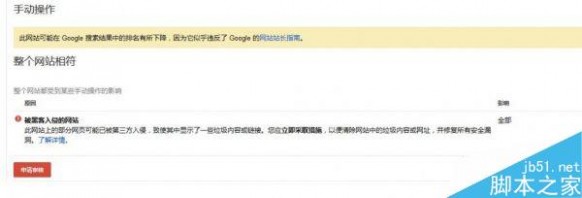

很多人会问,影响网站的不利因素多了去了,为什么重点说这几个? 因为Daniel在接优化的单子的时候,发现出现此类问题的人特别多,并且谷歌响应的速度特别快。举个例子:一个做仿牌的朋友做黑链(利用DIV+CSS 隐藏锚文本),但是我观察了许久,该网站并没有被降权。相反,当仿牌的手段从黑链转变成黑页(在被黑的SHELL里,大量导入HTML页面,生成大量的反 向链接页面)时,就如第二条所说的,谷歌站长就会立刻检测的到(时间不会超过7天),并且加入人工干预(Manual Action), 如图所示:

被加入人工干预的网站,排名会直线下滑,而且短时间内网站排名都很难恢复,所以,这是为什么把第二条列入到主要因素来讲。

为防止网页被大量生成无价值页面而且被谷歌发现,Daniel这里有一个基于Wordpress被黑而不被谷歌监测到的办法。当然,这不是一劳永逸的办法,关键还是要自己做好网站的各项安全防护。

目前很多新手存在误区,就是认为把目标关键词密度做到部分SEO论坛所说的7%-11%就是最好的, 其实不然,目前谷歌更看重的是LSI词的比重。

一个页面如果出现5次同样的目标关键词和一个页面只出现2个目标关键词,3个LSI词,后者的排名会更高一些;

而目标关键词密度,我个人认为只要在该放目标关键词的地方(H1标签,标题)等,放置好就好,没必要刻意去堆积。

如果你还是特别看重关键词密度,Daniel推荐你使用SEOBOOK关键词密度衡量工具,会比国内的工具更加准确一些

三 : 2016影响谷歌搜索引擎排名的几个重要因素

新的一年又开始了,有不少读者和我说他的网站上不去。当我问起他做了哪些优化,他便按照某些书本所说的标题标签包含关键词啊,H1标签包含关键词 啊,站内的锚文本用或者标签啊,等等,基本书本所说的他都照做了,而没有效果其实也是情理之中的事情。因 为这些都是别人很多年前总结出来的因素,对于当年确实很有用,但现在很多SEO因素都被削减了排名比重。既然我们要做排名,那我们肯定要先了解到谷歌目前 更看重哪几个点。这里daniel总结了几个2016年,谷歌比较看重的几个有利因素以及不利因素。

影响谷歌搜索引擎排名的有利因素

TR,也就是TrustRank,指的是网站的权威度。意思就是您的网站是否收到来自被信任的网站的链接;

DA, 也就是Dmoain Age, 域名年龄,也称为域名权重,时间越长的域名对排名越有利;

PR, Page Rank, 虽然他影响排名的比重从以前的70%下降到40%,但它仍然是影响排名的主要因素;

更新频率(update frequecy),指的是你的网站更新原创内容的频率;

LSI (Latent Semantic Indexing), 网页是否加入潜在语义索引词来替换部分目标关键词;

Soscial Media,也就是Facebook,Twitter,Pinteret在您的网页表现的数据。(你的页面有多少个赞,多少个转载,以及转载您的文章的改用户的权威度等)

手机自适应,或者使用目前谷歌刚推出的AMP项目,让你的网站在手机端能够更好的展现并且提升加载的速度。

并非H标签,加B标签在主要关键词上这些优化手段完全没用,而是这部分的优化手段已经从“要求”变成了“标配”,所以这里就不一一再多说。

不是把有利因素都做好了排名就上去了,因为在优化的过程中避免不了和不利因素打交道,我们在进行优化的过程中也要注意以下几个谷歌更为看重的不利因素要点:

影响谷歌搜索引擎排名的几个不利因素

页面导出大量不相关的链接,或者导出到不被信任的网站;

网页生成了大量的无价值页面;

反向链接只优化特定的词,目的性过强(参考引入LSI的作用);

站内关键词出现频率过高,优化过度;

在已经被列入链接工场的站长处购买链接;

外链的形式单一,长期从单一的站点内获取链接;

很多人会问,影响网站的不利因素多了去了,为什么重点说这几个? 因为Daniel在接优化的单子的时候,发现出现此类问题的人特别多,并且谷歌响应的速度特别快。举个例子:一个做仿牌的朋友做黑链(利用DIV+CSS 隐藏锚文本),但是我观察了许久,该网站并没有被降权。相反,当仿牌的手段从黑链转变成黑页(在被黑的SHELL里,大量导入HTML页面,生成大量的反 向链接页面)时,就如第二条所说的,谷歌站长就会立刻检测的到(时间不会超过7天),并且加入人工干预(Manual Action), 如图所示:

被加入人工干预的网站,排名会直线下滑,而且短时间内网站排名都很难恢复,所以,这是为什么把第二条列入到主要因素来讲。

为防止网页被大量生成无价值页面而且被谷歌发现,Daniel这里有一个基于Wordpress被黑而不被谷歌监测到的办法。当然,这不是一劳永逸的办法,关键还是要自己做好网站的各项安全防护。

目前很多新手存在误区,就是认为把目标关键词密度做到部分SEO论坛所说的7%-11%就是最好的, 其实不然,目前谷歌更看重的是LSI词的比重。

一个页面如果出现5次同样的目标关键词和一个页面只出现2个目标关键词,3个LSI词,后者的排名会更高一些;

而目标关键词密度,我个人认为只要在该放目标关键词的地方(H1标签,标题)等,放置好就好,没必要刻意去堆积。

如果你还是特别看重关键词密度,Daniel推荐你使用SEOBOOK关键词密度衡量工具,会比国内的工具更加准确一些

原文链接:http://www.seodaniel.com/important-factors-of-google-search-rank-in-2016/ 转载请注明出处

本文标题:基于谷歌的搜索引擎-分析谷歌对PDF文件的索引功能61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1