一 : 掌握搜索引擎的三大定律 打造高质量网站

相关性定律

相关性定律是基于搜索引擎检索系统的,相关性定律主要是基于词频统计,当用户在搜索引擎首页输入检索词时,搜索引擎去找那些检索词在文章(网页)中出现频率较高的,位置较重要的,再加上一些对检索词本身常用程度的加权,最后排出一个结果来(检索结果页面)。也就是说如果你一个站点里面关键词出现的次数较多,相关性就越强,就越有利于排名,但是有一定要注意,就是不能形成关键词堆砌了,这样的话文章是较难被收录的。还有就是关键词出现的位置,比如标题靠前的位置,文章靠前的位置等等。这些都是关键。

人气质量定律

科学引文索引的机制告诉我们一个道理,就是谁的论文被其他人文章引用的次数越多,谁就被认为是权威,论文就是好论文。不能得出,一个网站也是同样的道理,如果你的网站链接被引用的越多,那么你的网站就是好网站,就是被足够的重视。在这里我们还要注意一个“超链接文本”。我们既然知道站点链接被互联网其他站点所引用的次数越多就足够说明你的站点越好。但是引用链接里面所包含的具体关键词就能够反映你的站点在那些方面较为突出。这样你的站点排名就较好。

用户点击定律

我们都知道,同样排名前20名的站点,用户会有一个选择的,一般来说用户是先找寻排名比较靠前的网站,但是如果他们没有找到他们所要的资料,那么他们就会继续找下去,直到找到自己的页面为止。一般对网站点击率产生影响的因素是2个。第一个就是你在搜索引擎索引列表中显示的标题和描述,这个对用户有极大的引导性。第二个就是你本身的内容对于这个关键词的相关性和质量度,比如搜索的关键词和你排名的页面内容是不是符合大众需求的内容。如果是,那么你的点击率肯定会迅速提升,这样就造成排名靠后的站点流量大于排名靠前的,这个时候就提供给搜索引擎一个信息,你的站点质量非常好,他就会根据算法把你的站点排到最前面。

总结:搜索引擎三大定律是一个基础知识,希望大家认真学习和领悟,并且把他关联到我们网站上面去,具体布局优化的细节。这样才能够对我们站点创造一个质量和流量很大的提升空间。本文原创,转载请保留链接:www.hf-liyi.com 谢谢!

二 : 移动网页搜索引擎优化的十个细节

现在的移动搜索引擎优化不仅仅只是给移动站排名,更重要的是还与PC网站排名有很密切的关系,当一个网站的PC端和移动端适配合理的话,至少可以给PC网站排名加10分,所以还没有做好移动搜索引擎优化的朋友,非常值得看一看此文。下面是久闻网移动站点排名的数据,给大家作为参考。

1、URL适配关系

如果你的网站是自动响应式的,那可以忽略这一点,如果你的PC站和移动站URL可以对应,请把对应的规则写到百度站长平台去,对应的方法有两种,一种是写规则,依葫芦画瓢,第二种是直接把移动和PC的URL整理出来,写成一个txt的文件,上传到百度去,让他自己去识别。

2、移动网站打开速度

在移动网站上打开速度远比PC站点重要,比较电脑的速度目前来讲还是比手机要快,最低标准要保持网站在3秒钟内打开,所以移动网站上劲量保持文字即可,不要搞的稀里哗啦的,这不比PC网站,这一点自动相应的网站优化起来稍微困难一点,可以试着将PC和移动站一起优化。

3、图片延迟加载

看到不少的自媒体APP上大多数都使用了图片延迟加载的技术,当然还包括淘宝、京东等大型电商网站都使用到了,如果在移动网站上没有特别的要求,尽量不要使用图片,当然为了让文字活起来,增加图片也是应该的,那就使用图片延迟加载的技术,既不影响网站的打开速度,又不会让用户觉得无图无真相了。

4、页面结构问题

既然做了一个移动网站,那就拿出一个移动网站的样式来,那种还需要缩放或者横向滚动的网站,就不适合做移动站点优化了,如下图所示:

当然如果页面设计的非常合理,但因为移动网站的位置有限,将广告位遮挡住网站的主题自然也是不利于搜索引擎优化的,如下图所示:

5、自动网站文字大小

在PC网站上并没有明确的说明要求网站文字大小,但是因为文字太小并且文字上分有链接,有可能会被搜索引擎认为这是故意做的隐藏链接,移动搜索引擎上,千万要注意文字的大小问题。百度官方的建议是:正文字号推荐14px,行间距推荐(0.42~0.6)*字号。

6、网站实用性

在移动网站上,百度最喜欢的是文字形式的网站,百度最不喜欢的是flash网站,所以尽量避免实用flash形式展现,另外视频音乐网站应当是直接播放,严禁欺骗用户下载播放器(这属于作弊行为),APP下载类的最佳体验是直接下载,而不是跳转多个页面后才可以下载,至于移动网站的文档类的,应当直接转成文字发布出来。

7、取消百度转码

部分做了移动网站的朋友,当你用移动端搜索引擎搜索你的网站的时候,你会发现,你的网站被百度强行转码了,那是因为他还没有识别到你的PC网站和移动网站的对应关系,这个时候你要取消百度转码,并且提交对应关系。

8、301与302

移动端和PC端关系是对应适配了,但用户看到的需要我们做一个跳转来调整,通常情况下是302跳转,为什么不是301呢,因为我们的PC站和移动站是一起存在的,而301则是永久定向,就意外着之前的URL将不复存在。这样可能会影响到PC站点的排名。

9、移动站sitemap地图

虽然说移动站的收录和排名几乎没有关系了,但收录自然是越多越好,至少不需要依靠PC的跳转来支撑排名,而移动页面的链接相对PC上的少,所以大多数链接蜘蛛一个一个爬起来是非常辛苦的,这个时候网站地图是重要文件了。

10、移动网页meta标签

强制让文档的宽度与设备的宽度保持1:1,并且文档最大的宽度比例是1.0,且不允许用户点击屏幕放大浏览;

iphone设备中的safari私有meta标签,它表示:允许全屏模式浏览;

iphone的私有标签,它指定的iphone中safari顶端的状态条的样式;

告诉设备忽略将页面中的数字识别为电话号码

来源:冯耀宗博客(微信号:394062665)原文地址:

三 : seo优化哪些网站细节是百度搜索引擎最为看重的

作为seoer,我们除了要不断的服务用户之外,对于我们要优化的搜索引擎的喜好也应该有一个非常清晰的认知,作为国内最大的搜索引擎百度,是国内用户数最多的搜索引擎,那么,站长而言我们在优化的过程中除了做好自身之外,就需要了解搜索引擎了解百度。

第一,百度搜索引擎对于网站评价的基础指标-内容质量度。 我们知道百度搜索引擎在针对站点文章考虑的时候其细节因素是非常多的,我们一定要在以下几个细节上做足功夫,首先,成本因素,成本是内容制作的付出和投入的精力,这个非常容易理解,一篇文章复制过来的或者自己原创的或者自己原创并配图说明的,其成本价值自然是不言而喻的,内容完整的完整性主要体现在一篇文章能否流畅的针对文章主题进行清晰明确的表达;信息真实有效指的是文章中的信息是随意创作的还是自己用心写作在或者是在专业性方面是非常突出。

第二,网页内容体验的评估指标-浏览体验度分析。不同的网页质量度,搜索引擎对于网页的评价也是大有不同的,就百度搜索引擎而言对于一些网页中夹带很多广告、网页中存在很多安全隐患,比如携带木马病毒,搜索引擎是毫不手软的,目前百度搜索引擎主要从内容排版、广告影响、访问速度等几个层面来对于网页内容质量度进行判断的。内容排版是网页最基础的元素,主要体现在文字的大小一致,段落层次、段落对齐等。广告影响主要表现在一些站点的弹窗、自带广告是否影响了用户的阅读行为。访问速度主要指的是,网站空间服务器的访问速度,让用户停留时间不要超过5秒,否则用户很可能会离失我们的站点。

第三,网页内容新鲜度评估-网页信息实效性分析。互联网发展至今信息充斥着整个网络,但是当下无论是搜索引擎还是用户对于信息的实效性都有着非常强的敏感性,无论是一个企业站点还是资讯类站点,信息的实效性是我们站点内容吸引用户的一大法宝,就企业站而言,产品的最新资讯、公司新闻的最新信息都可以作为网页内容的来源素材,而这些信息资源也正式搜索引擎分析、考察我们站点内容新鲜度的一项非常重要的指标。

最后,笔者总结一下笔者在优化网站的过程中一直以百度的要求和规则为优化指南,就内容而言从来不会为了更新内容而更新网站,内容是自己对于产品或者公司新闻的认知,感觉这篇东西能够为用户带来价值,能够提升自己企业的形象和价值,这个时候才会斟酌进行发布,内容优化没有很多高深的东西,踏踏实实服务用户,我认为这就是最好的优化方法。来自 老谭世家 http://www.laotansj.com 原创首发站长网,转载请注明笔者版权信息,谢谢合作。

四 : 网站优化seoer要了解搜索引擎和用户之间的关系

我们知道,网站优化我们站长说是为用户服务其实本质上是在围绕搜索引擎的目的在为用户提供其最需要的内容,在这个过程中,站长必须对于搜索引擎和用户之间的关系有一个深刻明确的认识,那么,笔者认为以下几个方面是我们要重点关注的。

第一,搜索引擎存在的目的和意义。互联网可以说是一个信息的大熔炉。在这个大熔炉中很多用户都希望通过互联网找到所需,但是大家不知道自己要寻找的信息在那里,这个时候就需要借助搜索引擎来帮助我们,直观的说,我们到一个陌生的城市难免会出现"路盲症",交警或者环卫工人就是我们可以询问的最好向导,而在互联网上搜索引擎就恰恰充当这这个角色。对于自己想要获取的信息无论是知识、视频还是新闻搜索引擎都会尽可能的为我们提供专业的回答,包括网站、问答、视频等可能我们没想到的细节,搜索引擎就为我们呈现出来了,这个正是搜索引擎的价值和意义,最短的时间帮助用户找到对于自己最有价值的信息。

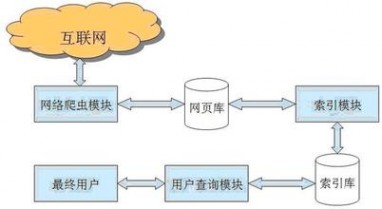

第二,搜索引擎寻找信息的过程分析。搜索引擎本身有着自己成熟的算法系统,我们所有人都不得而知,但是我们可以通过对于搜索引擎原理和搜索结果的推断进行分析这个搜索过程,基本原理包括搜索引擎对于互联网信息的抓取,对于有效信息的消燥、去重一系列的算法最终为这些都是信息建立索引库,通过对于网页内容的判断分析结合自身算法給于由高到低的一个网页排序。这个过程中我们可以做些什么呢?我随便举例说明,比如用户搜索"奶瓶"这个词语,按照常理可能我们认为用户想要购买奶瓶,其实不尽然,用户可能会了解奶瓶的种类、奶瓶价格、奶瓶厂家等一系列的问题,有些用户思维非常简单他本身搜索的是奶瓶其实真正想了解的是奶瓶那些牌子的比较好,作为站长我们就要挖掘用户搜索信息的潜在价值,明白这些在我们网站或者推广过程中多进行换位思索,多角度的去迎合用户的这种想法,那么,你的目的就和搜索引擎的价值保持在一个相对吻合的层面,你推荐的信息是非常有可能被搜索引擎提升在一个显著的位置上的。

第三,作为站长我们应该做点什么事情呢?站长担负着整个网站的运维过程,我们必须对于每一个细节都要做好认真的把握,就网站而言,我们需要关注用户搜索词,通过自己的站点把与之相关的词语建立栏目、频道或者内容页面来进行文章的构思或者布局,让自己网站成为一个专业细分领域的小型信息库,那么,你自己站点中与用户所求信息的相关度性越大,搜索引擎推荐你站点的几率也就越高,所以,笔者认为优化不是每天盲目的发布文章做外链,你需要重点分析自己的用户,看看用户关注的点,然后我们针对性的部署和调整网站细节,这个才是优化网站的真正意义也是站长最应该值得关注的问题,但是很多朋友搞反了,为了迎合搜索引擎拼命的发布内容和链接,链接质量低下内容没质量,搜索引擎收录内容了用户不买账因为没价值,这个时候你网站权重即使提升也是昙花一现。

最后,笔者总结一下,整篇文章笔者没有站在搜索引擎和现在正常优化的思路下分析,而是站在我们最需要关注的用户和搜索引擎两者之间的关系层面为大家阐述关于运维优化和搜索排名之间的含义,饮水思源,治病治根。从根上去明白两者之间的关系,找到彼此之间的共性就是seoer可以发挥和做文章的地方了,看到这里你懂了吗,优化很简单,只是很多人夸大了而已。好的,来自西安蓝田玉网 http://www.029lty.com 原创首发站长网,转载请注明笔者版权信息,谢谢合作。

五 : robots协议对网站、搜索引擎的重要性

很多站长最头疼的一个问题就是,搜索引擎蜘蛛为什么不光顾自己的网站,或者光顾频率比较低。这样对网站收录的影响是比较大的,直接影响到网站的排名。

先谈一下搜索引擎蜘蛛的工作原理吧,蜘蛛又称网络爬虫、网页蜘蛛、网络机器人,更生动的叫网页追逐者。一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

网络爬虫

你知道万维网中有多少蜘蛛吗?下面介绍一下全球知名的蜘蛛,NO1:谷歌蜘蛛:google 谷歌蜘蛛最新名称为“compatible; Googlebot/2.1;” “Googlebot-Mobile”,看名字是抓取wap内容的:,全球最大的搜索引擎公司。NO2:百度蜘蛛:Baiduspider 常见百度旗下同类型蜘蛛还有下面这些Baiduspider-mobile(wap引擎)、Baiduspider-image(搜图引擎 )、Baiduspider-video(视频引擎)Baiduspider-news(新闻引擎),中文搜索引擎最强的公司。NO3:360蜘蛛:360Spider。NO4:SOSO蜘蛛,NO4:Sosospider 雅虎蜘蛛,NO:5“Yahoo! Slurp China”或者Yahoo!NO6: 有道蜘蛛:YoudaoBot,YodaoBot,NO7: 搜狗蜘蛛:Sogou News Spider,这些是全球最出名的蜘蛛,其实还有好多我就不一一列举了。

蜘蛛特点就是通过结网来捕获猎物,所以我们的网站就跟猎物一样等蜘蛛来捕获,如果网站内容新颖独特,更新内容频率高蜘蛛就会经常光顾你的网站。但是也不能让蜘蛛随便抓取,比如后台地址,所以就有了robots这个协议,这个很重要如果robots.txt协议写的好可以事半功倍。下面介绍一下robots.txt协议怎么写可以迎合蜘蛛的口味:

User-agent: *

开头字母必须是大写的,后面加英文形式下的冒号,然后后面是空格。

*表示通配符号。这里指通配所有的搜索引擎。

Disallow: / 表示禁止搜索引擎爬取所有页面,/表示目录。

Disallow: 表示不禁止

Disallow: /admin/禁止爬取admin后台目录。

Disallow: /admin 禁止抓取包含admin的路径 后面不带/表示只要路径中包含admin蜘蛛就不会抓取。

Allow: 表示允许

Allow: /admin/s3.html 允许抓取admin目录下的s3.html 这个文件。

Disallow: /.css$ 表示以.css结尾的文件都不允许抓取,带上$表示特定的文件。

3.robots.txt协议写法注意点

注意:

所有的语法必须空格/开头,所有正规的搜索引擎在抓取网站URL的时候会第一时间抓取robots.txt,如果没有robots.txt文件,蜘蛛会默认网站允许抓取所有信息。

网站地图放在robots.txt文件里。

所以把网站地图放在robots.txt文件夹里可以让蜘蛛更快速的抓取网站路径。 把做好的XML地图写在robots.txt文件里上传根目录就好。

总结:robots协议对伪静态的网站很重要,如果没有robots协议搜索引擎就会重复收录对网站权重排名有影响。robots协议最后必须加入网站地图,这样才会更好的引导蜘蛛抓取你的网站。

本文由盐城SEO吉中春原创,原文地址,转摘请保留版权,谢谢。

本文标题:网站搜索引擎优化-掌握搜索引擎的三大定律 打造高质量网站61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1