一 : 如何让网站更好的吸引搜索引擎

网络营销已经成为营销的一种主流趋势,越来越多的企业选择网络营销,网络营销的方式也是很多,其中搜索引擎营销可能更受企业的重视。营销型的网站需要通过SEO优化的方法,提高网站在搜索引擎中的排名。下面A5站长网SEO诊断团队(http://www.yuehuai.com/seozhenduan/)浅谈下对于营销型的网站要怎么做才能更好的吸引搜索引擎,让网站在搜索引擎中有更好的排名。

第一:提高网站自身权重。网站自身的权重高,自然会被搜索引擎喜欢,搜索引擎赋予老网站的权重比新站的高,权重高的网站自然占据优势。网站的权重大部分是来自网站高权重的外链,搜索引擎认为有高质量外链的网站权重自然也高,这里的外链也包括友情链接。所以选择相关性的网站,高权重的网站交换友链是很必要的。同时,网站的权重也跟网站的域名年限,网站的稳定性有关联,域名时间长、网站空间稳定的网站,搜索引擎自然会喜欢这样的网站,并赋予很稳定的排名。

第二:提高网站内容原创相关性。营销型的网站在运营之初就应该定位好网站的关键词,网站在正式运营之际要写和网站定位相关的内容。用户通过搜索引擎搜索关键词,既而进入排名比较好的网站,要想让搜索引擎更好的喜欢网站,网站需要提高网站内容与关键词的相关性,网站可以通过提高网站原创的新闻内容、关键词在首页布局、网站内链、关键词锚文本外链等来提高网站的网页相关性。这里要提醒大家的是虽然要提高网站的相关性,但是网站不可去采集伪原创,伪原创的内容即使跟网站的相关性,但是对网站的作用不大,采集的内容很难对搜索引擎收录,而且会影响网站的用户体验,大量采集的网站还可能会被搜索引擎K站,相关性要提高,但是不要作弊。

第三:提高网站的用户体验度。说要更好的吸引搜索引擎,还不如说更好的吸引用户,用户喜欢的网站,搜索引擎才会更喜欢。网站优化时一定要提高网站的用户体验度,网站的结构建设要清晰、导航要方便实用、网站要加入分享收藏按钮。营销型的网站更讲究的是网站的实用性,网站更多的是要像用户展示产品的用途、特点和产品的实际操作方法,而不是大量的使用flash,网站加载速度慢,用户很难访问网站,搜索引擎也抓取不到flash的内容。网站中使用的图标尽量使用alt标签标注,对于电子商务类型的网站最后设置在线咨询,或者在线留言系统,最好不要使用漂浮的弹窗模式,营销用户的体验。只有网站有了很高的用户体验度,用户转化率高,搜索引擎才会更喜欢你的网站。

站长们要想让网站更好的吸引搜索引擎,能有更好的排名,就得研究搜索引擎想要什么,网站能给用户提供什么,只有把网站的自身权重、网站的内容和网站的用户体验度都提高了,网站才能更好的吸引蜘蛛,更长期的占据搜索引擎首页的位置。常州人才网www.job0519.com投稿原创

二 : 如何提高搜索引擎友好度?你的网站躺枪了没有?

做网络营销的基础是网站本身,而做好网站SEO第一个关键就是网站本身对搜索引擎的友好的,不会出现搜索引擎不可读取的现象,致使spider以后“过站而不入”。

一般来说,我们认为对搜索引擎不友好的网站通常是有大量JS代码或者Flash站,但是事实真的是如此吗?今天就和笔者一起来分析那些影响搜索引擎友好的因素,一起来看看你的网站躺枪了没有?

第一,要排名就首先要被搜索引擎读取。

通常来说网站要参与排名的必要前提是被收录,如果你的网站中存在了大量不可读元素就会造成网站全局不能被读取,这就是不友好搜索引擎的因素之一了。粗略看来,我们认为框架网站、JS代码过多的网站和Flash因为不能够被读取使得网站的收录不佳。而实际情况是,我们只看到了片面的一方,就现在的搜索引擎而言,这些语言尚且不能被读取,但是并不是说网站存在这些语言就不能被读取,他们会造成部分读取。很多网站为了吸引客户,精彩是页面设计是不可或缺的,所以网站只要不的全局不可读,那么对网站SEO来说影响并非重大。

第二,要用户就首先要有稳定的网站。

所谓稳定的网站就是网站不会经常出现,网页打不开或则访问速度太慢的情况。这种情况除了不能控制的服务器空间问题还有主管因素包含在其中。主要就是网站的本身的容积,我们可以在不影响页面质量的情况下,尽量将网站整体缩小化,这样在一定程度上可以提升网站访问时间。而我们要做的就是做好监测工作,及时解决网站非不可抗因素而造成的网站不稳定现象。

第三,要稳定就首先要固定网站元素。

网站大幅度变更会影响网站优化,为了获得好的排名流量很多SEOer都会将最新的优化技术生搬硬套到网站中。而其中最常被波及的就是title和meta标签,频繁修改此类元素就会造成搜索引擎的误会,对搜索引擎而言是很不友好的表现。更甚者还会整改网站的路径、程序和页面主版块,这样的大起大落要先做获得搜索引擎的好感真心有点困难。我们可以进行微调,但是要做整体更改要格外慎重,即便万不得已需改时也可以做好网站的301或者直接闭站保护。

第四,要收录就首先要清晰的网站结构。

网站结构是笔者小丹在SEO优化中经常谈到的话题了,扁平化的树状网站结构无论是在爬行的深度还是广度上都是有优势的。不过这里我们还有提醒一点,清晰的网站结构要“枝叶分明”,交接点也要有相关联系。而对于一些比较大的网站,在使用二级域名时候要慎之又慎,万不可开辟大量的无意义二级域名而增加网站的冗杂网页,这样的垃圾页面对搜索引擎的是不友好,同时也会影响对网站友好程度。

第五,要友好就首先要避免重复。

搜索引擎对于页面会不停的更新抓取然后备注在数据库中,但是对于一个网站的相同页面则不会有这么好的耐心了。这种情况多出在伪静态网站中,为了加速网站的快照更新很多站长都会重新生成一个静态页面,而对原有的动态页面却没有用任何手段来进行屏蔽。这样就会造成网站一信二页的情况,而且其路径还是不相同的,很影响搜索引擎对网站的友好程度,为了避免此种现象笔者小丹建议我们还是使用robot文件进行屏蔽吧!

(转载请注明转自:www.wangzhan.net.cn,谢谢!珍惜别人的劳动成果,就是在尊重自己!)

三 : 浅谈搜索引擎蜘蛛抓取网页规则

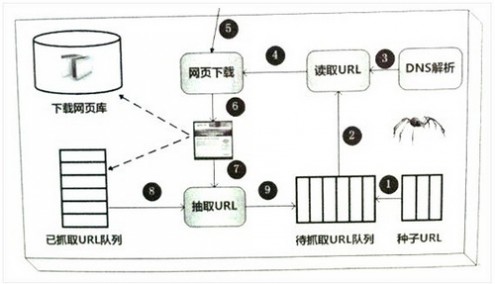

一,爬虫框架

上图是一个简单的网络爬虫框架图。种子URL入手,如图所示,经过一步步的工作,最后将网页入库保存。当然,勤劳的蜘蛛可能需要做更多的工作,比如:网页去重以及网页反作弊等。

也许,我们可以将网页当作是蜘蛛的晚餐,晚餐包括:

已下载的网页。已经被蜘蛛抓取到的网页内容,放在肚子里了。

已过期网页。蜘蛛每次抓取的网页很多,有一些已经坏在肚子里了。

待下载网页。看到了食物,蜘蛛就要去抓取它。

可知网页。还没被下载和发现,但蜘蛛能够感觉到他们,早晚会去抓取它。

不可知网页。互联网太大,很多页面蜘蛛无法发现,可能永远也找不到,这部份占比很高。

通过以上划分,我们可以很清楚的理解搜索引擎蜘蛛的工作及面临的挑战。大多数蜘蛛是按照这样的框架去爬行。但也不完全一定,凡事总有特殊,根据职能的不同,蜘蛛系统存在一些差异。

二,爬虫类型

1,批量型蜘蛛。

这类蜘蛛有明确的抓取范围和目标,当蜘蛛完成目标和任务后就停止抓取。具体目标是什么?可能是抓取网页数量,网页大小,抓取时间等。

2,增量型蜘蛛

这类蜘蛛和批量型蜘蛛不同,他们会持续不断的抓取,对于抓取到的网页会定期抓取更新。因为互联网中的网页是随时处于更新状态中,增量型蜘蛛需要能够反映出这种更新。

3,垂直性蜘蛛

这种蜘蛛只关注特定主题或者特定的行业网页。以健康网站为例子,这类专门的蜘蛛会只抓取健康相关主题,其它主题内容的网页则不抓取。考验这只蜘蛛的难点是如何去更精准的识别内容所属于行业。目前来看,很多垂直类行业网站是需要这种蜘蛛去抓取的。

三,抓取策略

蜘蛛通过种子URL进行爬行拓展,列出大量待抓取URL。但是待抓取URL数量庞大,蜘蛛如何确定抓取顺序先后呢?蜘蛛抓取的策略有很多种,但最终目的是一 个:优先抓取重要的网页。评价页面是否重要,蜘蛛会根据页面内容原创程度,链接权重分析等众多方式来进行计算。比较有代表性的抓取策略如下:

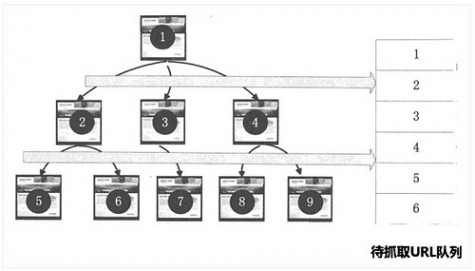

1,宽度优先策略

宽度优先是指:蜘蛛在抓取一个网页后,继续将该网页所包含的其它页面按顺序进行进一步抓取。这种思想看似简单,其实却很实用。因为大多数网页都是按优先级进行排序,重要的页面会优先在页面上进行推荐。

2,PageRank策略

PageRank是一种非常著名的链接分析方法,主要是用来衡量网页权重。如谷歌的PR,就是典型的PageRank算法。通过PageRank算法我们可以找出哪些页面是更重要的,然后蜘蛛优先去抓取这些重要性的页面。

3,大站优先策略

这个很容易理解,大网站通常拥有更多的内容页面,并且质量也会更高。蜘蛛会先分析网站归类与属性。如果这个网站已经收录很多,或者在搜索引擎系统中权重很高,则优先考虑收录。

四,网页更新

互联网中的页面大多会保持更新,这样就要求蜘蛛所存储的页面也能及时更新,保持一致性。打个比喻:一个网页之前排名很好,如果页面已经被删,却还有排名,那 体验就很不好。因此搜索引擎需要随时了解这些并更新页面,将最新的页面提供给用户。常用的网页更新策略在三种:历史参考策略,用户体验策略。聚类抽样策 略。

1,历史参考策略

这是建立在一种假设基础上的更新策略。比如,若你的网页之前按规律一直更新,那搜索引擎也认为你的页面将来也会经常更新,蜘蛛也会按这个规律定期来网站进行抓取网页。这也是为什么点水一直强调网站内容需要有规律更新的原因。

2,用户体验策略

一般来说,用户只会查看搜索结果前三页的内容,后面的页面很少有人去看。用户体验策略就是搜索引擎根据用户的这个特点来进行更新。例如,一个网页可能发布时 间较早,一段时间没更新,但是用户依然觉得有用,点击浏览它,那么搜索引擎先不去更新这些过时的网页也是可以的。这就是为什么搜索结果中,并不一定最新的 页面排名一定靠前的原因。排名更多的是取决于这个页面的质量,而完全不是更新时间先后。

3,聚类抽样策略

上两种更新策略主要是参考了网页的历史信息。但存储大量历史信息对搜索引擎来说是一种负担,另外如果收录的是新网页则是没有历史信息可以参考的,那怎么办? 聚类抽样策略是指:根据网页所展现出来的一些属性,来将很多相似网页进行归类,被归类的页面按照相同的规律去进行更新。

从了解搜索引擎蜘 蛛工作原理的过程中,我们会知道:网站内容之间的相关性,网站与网页内容更新规律,网页上链接分布以及网站权重高低等因素都会影响到蜘蛛的抓取效率。知已 知彼,让蜘蛛来得更猛烈些吧!

本文标题:搜索引擎如何抓取网页-如何让网站更好的吸引搜索引擎61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1