一 : 搜狗搜索加入AMP 开源计划 与Google共同推动移动网页加速

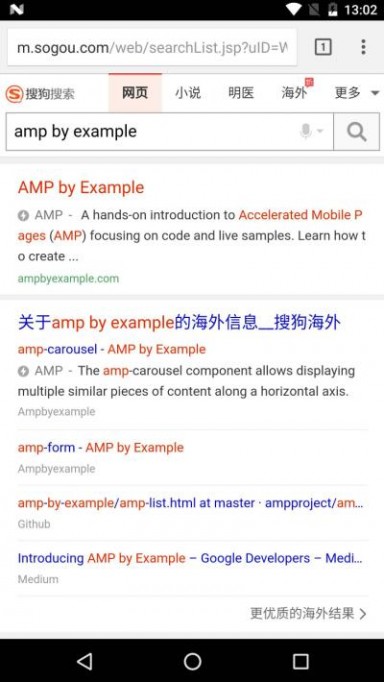

3月7日,第一届AMP开发者大会(First AMP Developer Conference)在美国纽约拉开帷幕,中国第二大搜索引擎——搜狗搜索出席峰会,并宣布加入AMP(移动网页加速)开源项目,成为其在中国的重要参与者。点击搜狗搜索结果中带有AMP标识的网站,中国用户即可享受AMP技术带来的秒开网页体验。

据了解,AMP是由以谷歌为代表的科技公司和内容发行商在2015年10月共同发起的改善移动网用户体验的开源项目,旨在提升移动网页加载速度。目前已有超过1万名开发者为AMP开源项目做出贡献,在世界范围内已有数以万计的网页文档支持AMP。搜狗搜索加入AMP开源项目,将与谷歌一起为这个项目提供技术创新,让移动网页加载速度变得更快,带给用户更加良好的使用体验。

近年来,在人工智能驱动下,搜狗搜索实现了技术与内容的差异化,成为改变中国搜索市场格局的唯一挑战者。搜狗搜索通过众多差异化产品,精准地虏获了中国当下年轻人的求知欲和好奇心。其中,搜狗海外搜索网罗全球英文资讯,并独创跨语言搜索功能,让不懂英文的年轻人搜索并阅读全球的英文资讯和内容,成为读懂世界的“窗口”。而搜狗搜索参与AMP开源计划,将为对海外资讯有需求的搜索用户带来直接利好,用户可在瞬间打开带有AMP标识的英文网页,快速获得和阅读全球资讯。

搜狗搜索成为AMP开源项目重要协作伙伴,只是一个开始。未来,搜狗搜索期待发挥中国第二大搜索引擎的优势,与Google等伙伴一同为AMP开源计划贡献更多技术和力量,为中国开发者创造更多机会,共同推动中国用户的搜索体验改善。

二 : Facebook正在加紧开发搜索和显示

如果有一家公司的使命,利用搜索和显示,它的Facebook上。最近的证据表明今年的社会巨头正加紧游戏跨两个通道- 搜索,他们已经宣布了图搜索,显示,他们已经取得了一致的公告,周围的Facebook交易所(FBX)大浪。

对搜索的影响

如今,脸谱作为一个网关连接到Internet,就像谷歌。到现在为止,各公司已经采取了自己的方式,通过特定通道 - 通过搜索和通过社会。最近,他们已经开始与图搜索侵犯彼此的草皮 - 谷歌的Google+社交网络和Facebook。

Facebook已经创建的图形搜索的是消费者的另一种搜索机制。最终,这可能打开了一些Facebook在搜索广告的形式,货币的机会。

此外,搜索引擎营销,这创造另一种途径达到目标受众的广告根据搜索活动。在Facebook上的差异是如何搜索功能的工作原理。而是一个有机的搜索,你会收到你的Facebook朋友的经验基础上的个性化的结果 - 他们已经走过的地方,他们喜欢什么品牌,他们遵循等。

随着中说,图搜索是相当有限的。这真的不是一个谷歌或Bing替代 - 很明显,搜索量将是相对较低的。这引出了一个问题:它是值得的营销?

要回答这个问题,我认为重要的是要记住,Facebook的社交数据提供搜索引擎营销,搜索广告业务的数据的另一个来源。想想所有的额外的数据点时可以使用搜索营销与搜索行为结合社会!

因此,答案是谨慎的。然而,为了真正腾飞,消费者实际使用图形搜索。直到通过图形搜索的增长,搜索广告在Facebook上不会扩展。

对显示的影响

在最近的白皮书中,“ Facebook的实时购买结婚,“约翰·Tuchtenhagen,Digitas的集团董事副总裁,被称为Facebook的交易”范围扩展“。

[W]第i个近一个亿Facebook用户,体积成为一个主要的资产为FBX,达到品牌延伸提供了一个全新的机会。

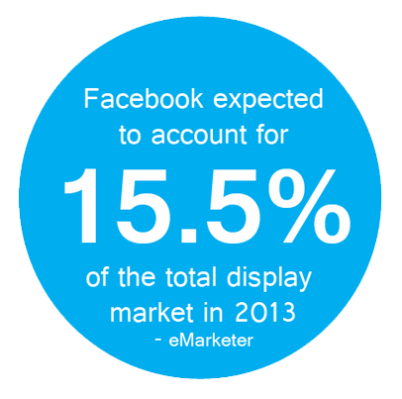

Facebook已经被证明是一个有价值的球员 在其最近公布FBX和创新新闻供稿广告背后-更不用提即将推出的 视频广告显示。今年早些时候,eMarketer的报告称,Facebook预计将占到总显示市场在2013年超过15%。FBX将可能有Facebook的显示广告支出,这是今年年底有望达到2.75十亿美元的整体份额影响最大。

这种影响不仅仅是因为创新或其巨大的用户基础。FBX也有一定的影响,通过提供更多的RTB库存,重要的是,RTB库存已知质量。FBX广告知道他们的广告将显示,他们也知道,这些广告显示机器人的风险是很低的,因为真正的用户登录到营销的价值不能被低估-让你通过RTB FBX买入一个已知的位置,用户正在积极从事的内容,避免被交付给机器人的印象。

即使有很多的价值可信的库存和体积,它是可能的营销范围内FBX上限。为了真正利用Facebook启用的值显示,营销人员需要使用第三方的数据,包括搜索数据重定向。此外,虽然公司继续从FBX报告阳性结果,我们都应该明白,FBX的大量供应库存加上便宜的价格将最有可能产生强劲的业绩为广告。所以,我们应采取这一额外来源显示的盐粮?不完全是。

随着Facebook继续加强超越社会和加强其跨渠道产品,营销人员应该希望有更多的机会为广告尺寸,定位和数据。我们不知道便宜的价格将持有多久,多少显示库存将是Facebook的交流上,以及如何快速图搜索将通过其庞大的用户群。只有时间会告诉我们到底有多少价值,Facebook将搜索并显示市场带来。本文由 http://www.suzhoujiaxiao.com 整理编辑,转载请注明!

三 : 分析robots.txt禁止页面出现在搜索结果中的影响

有的是时候,你会惊奇的发现,明明在robots.txt中禁止收录的页面,却出现在了搜索引擎结果列表中,特别是在site:的时候最容易发现。这是你可千万不要惊慌,去怀疑是否robots.txt语法规则写错了。

robots.txt里禁止的页面为什么出现在搜索结果中

robots.txt禁止抓取的文件搜索引擎将不访问,不抓取。但要注意的是,被robots.txt禁止抓取的URL还是可能出现在搜索结果中,只要有导入链接指向这个URL,搜索引擎知道这个URL的存在,虽然不会抓取页面内容,但是可能以下面几种形式显示在搜索结果中:

只显示URL,没有标题、描述。

显示开发目录或雅虎等重要目录收录的标题和描述。

显示导入链接锚文字作为标题和描述。

之所以这样处理的重要原因是,搜索引擎虽然不搜录该页面,但由于有很多链接链向这个页面,因此它认为这个页面是有价值的,可能和用户在这发生的搜索行为目的有密切关系,因此显示出来,但为了尊重站长,又不显示URL的详细信息。

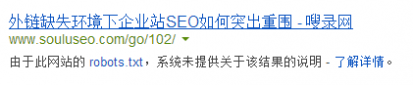

如上图中,谷歌仍然将本站的一个跳转链接显示在搜索结果中,并在网址下方提示“由于本站的robots.txt,系统未提供…”,而结果标题不是这个跳转页面的<title>,而是链接到这个跳转页面的锚文本,你可以试试上面的那个地址,验证效果。

如何真正实现禁止收录

这里要谈的不是“禁止收录”,而是“禁止索引”,上述情况就是禁止收录了,但搜索引擎仍然对网页进行索引,在用户需要时返回它认为可靠的信息。在已经添加到robots.txt中作为规则之后,为了彻底将这些页面从搜索引擎结果列表中去除,我们可以通过以下几种方式。

1、使用meta robots标签

在这个不像被收录(索引)的页面头部加上下面的代码

<meta name="ROBOTS" content="NOINDEX,NOFOLLOW,NOARCHIVE" />

其中NOINDEX即禁止索引本页,搜索引擎中将不会返回本页作为结果。NOARCHIVE指不建立快照,百度支持它,百度好像暂不支持NOINDEX。NOFOLLOW指蜘蛛不会跟随本页内的链接继续爬行,也不会传递本页的权重。注意一个事实,链接流动和传递权重是与禁止索引不等效的,也就是说,如果你只是使用下面的代码,那么这个页面将不会被返回到搜索结果中,但是页面上的链接还是会被蜘蛛爬行,权重还是会顺着它们往下传递。

<meta name="ROBOTS" content="NOINDEX,NOARCHIVE" />

2、在链接向这个页面的锚链接加rel=”nofollow”

既然你已经在robots.txt中禁止抓取这个页面,肯定不想让其他链接来到这个页面,因此,你可以在链接上加上rel=”nofollow”,这样蜘蛛就不会再跟着这条链接爬到你禁止抓取的页面了,也不会把权重传到那个页面了。不过如果锚链接是别人写在他们自己的网站里面,这就没有办法了,只能使用第一种方法。

这种现象对SEO有什么影响

首先,我们需要明确,到底该不该禁止这些页面的搜录。网页禁止收录的原因有多种,或许你不希望别人查看你的隐私,或许由于网页的内容不重要,或许这个网页就像我的一样是一个跳转页面,最好不要收录。可是,这种不收录是否对SEO有比较好的影响才是我所关注的,如果不收录导致坏的SEO影响,而那些页面也无关紧要,那我们就让它收录不就可以了。可是,这种不收录的影响具有两面性,有时好,有时坏,要看如何操作。

如果由于网页价值差,而不搜录页面,未尝不可,但是如果由于禁止了这个网页的收录,也就失去了链接流的传递环节,网站内的链接由此断裂了,导致权重传递在这里中断甚至消失,那么就是坏的影响。例如某一个在线留言页面,站长觉得它不重要,也不希望其中的内容在搜索结果中展现,因此禁止它收录了,但是一个网站结构的页面只有从这个页面才能进入,那么这样的话,这个页面就没有办法被搜索引擎抓取了,可是正是由于这个页面把网站结构串联起来,是一个非常关键的页面,这样一来,网站就面临了巨大的损失。另一种情况是,大量的网页链接到这个页面,它集中了大量的权重,可是你却规定它不被收录,这样一来它所获得的这些权重就浪费了,也不传递给别的网页,这就是权重黑洞。

当然也有好的影响,例如上述我的网站的跳转页面,我将它们禁止收录之后,它们就不会出现在搜索结果中,用户不可能进入这种没有意义的页面,更不可能进入我的网站,还没停上半秒钟就进入别人的网站。另外,我在导入这些跳转页面的链接上加了rel=”nofollow”,既防止了页面被抓取,也避免了将权重传递到其他网站。

不过也有人利用这种robots.txt的特性来欺骗搜索引擎,例如有人制作了一个H网页,由于它的内容是不好的,因此他用robots.txt将它隐藏起来,但是又不禁止收录,并且在其他网站做了一些外链,而这些外链的锚文本与网页的内容没有关系。在这种操作下,就会出现我在上文中给出的那张图片一样,搜索结果的标题是锚文本的标题,但实际网页内容是另外的内容,以实现欺骗搜索引擎和用户的目的。

四 : 对百度新上线“网页搜索结果robots出现提示”的理解

robots.txt文件,SEOER们都知道,就是可以设置你网站的哪些内容允许蜘蛛抓取,哪些不允许蜘蛛抓取的一个文件。今日,据百度站长平台最新消息,用户在百度搜索网址或相关关键字时,网页搜索结果会出现robots提示。简单地说,如果你的网站设置了robots文件,并且是不允许蜘蛛抓取的,而这个网站对用户有是有需要的,百度就是根据你输入的网址或相关关键字展示这个网站,不过,这和其它网站不一样,搜索的结果只出现title中的部分关键字,并且不会出现这个网站的元标签描述部分。对应的元标签描述部分将由最新上线的robots提示代替,比如,用户在搜索淘宝网时,出现“由于该网站的robots.txt文件存在限制指令,系统无法提供该页面的内容描述 - 了解详情”字样。

百度这一动作,意味着什么,笔者就个人看法谈谈百度些次网页搜索结果robots出现提示的意义及特点。

对搜索结果出现robots提示的理解

前面和大家说到,如果你的网站设置了robots文件,而且是禁止百度蜘蛛抓取的,但是你的网站又是百度需要的,用户在搜索该网址或网站名称时,就会出现robots提示。百度官方在提高,百度蜘蛛会根据robots协议来是否抓取,并呈现结果在搜索结果中。从中我们看到,个人认为百度是爬行了这网站,只不过是没去收录并呈现在搜索结果中而已,不过,笔者也测试了一个网站,如果百度蜘蛛没去爬行,就算你的网站写了robots文件,并且是禁止百度蜘蛛抓取的,搜索结果还是不会出现robots提示的,也许是百度认为这网址不是用户有需要的吧。不过,还真不知道蜘蛛是如何确定一个网站是否是用户需要的,个人感觉,一个网站如果禁止百度蜘蛛抓取,如果搜索结果中要出现robots提示,那么这个网站一定是蜘蛛爬行过的,并且是对用户有用的。

搜索结果出现robots提示是为提升用户体验

像淘宝这样的大网站,知名度那么高,虽然很多用户在访问淘宝网时不会出现去百度搜索,而是直接访问淘宝网,不过,如果用户在百度搜索结果中出现找不到结果,明显是对用户体验不好的,百度这一举动,可以说是在不断地提高用户体验。前些天笔者在用google的时候就发现了这一功能,明显,google比百度这在方面做得更好,因为笔者一个网站在改版时,设置了robots文件禁止google robot抓取,所以返回的结果就像百度网页搜索结果一下,出现了robots提示。

文章由 模具厂 www.wkt-mould.com 原创,转载请说明出处!

本文标题:打开网页出现搜索提示-搜狗搜索加入AMP 开源计划 与Google共同推动移动网页加速61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1